Explicación formal de qué es la IA

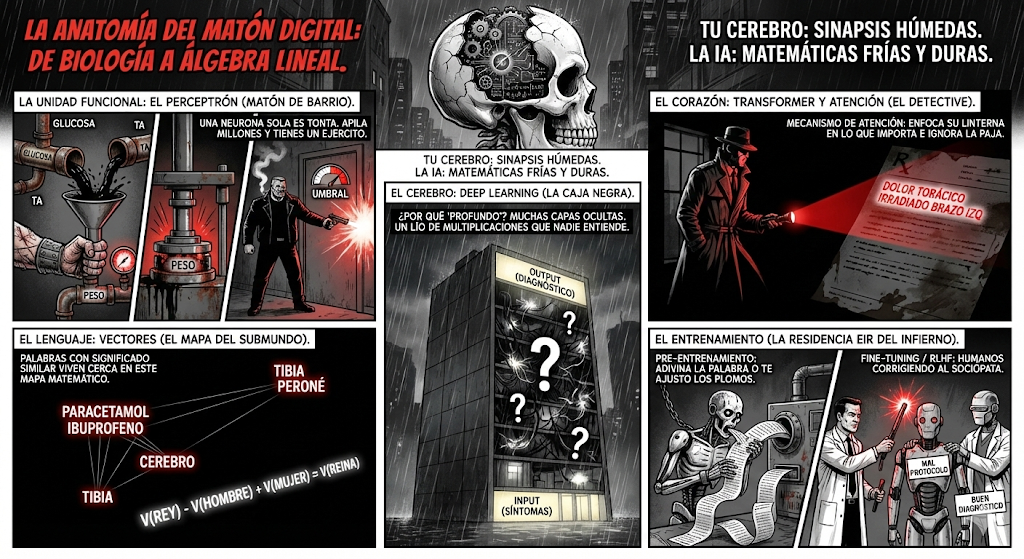

Para entender esto, tenéis que cambiar vuestro chip mental de "Biología" a "Álgebra Lineal". Pero tranquilos, que os lo traduzco a medicinaese.

La Unidad Funcional: La Neurona Artificial

En vuestro cerebro, tenéis neuronas conectadas por sinapsis que transmiten impulsos eléctricos. En la IA, tenemos Perceptrones.

Imaginad una neurona artificial como una función matemática simple:

Inputs (Dendritas): Recibe datos de entrada (ej: niveles de glucosa, tensión arterial).

Pesos: Esto es la "fuerza" de la sinapsis. La IA asigna una importancia a cada dato. ¿Es más importante la TA o la glucosa para predecir un infarto? La IA ajusta este "peso" durante el entrenamiento.

Suma Ponderada y Sesgo: La neurona suma todo: Sumatorio (Input x Peso)+ Sesgo

Función de Activación (Axón): Decide si la neurona "dispara" o no. Es como el potencial de acción. Si la suma supera un umbral, pasa la señal a la siguiente capa.

Traducción clínica: Una sola neurona artificial es tonta. Pero si apilas millones de ellas en capas (Deep Learning), pueden aprender patrones complejos, igual que un tejido forma un órgano.

El Cerebro: Redes Neuronales y "Deep Learning"

Aquí es donde la gente se lía.

Machine Learning (ML): Es el campo general. Es enseñar a la máquina a aprender de los datos en lugar de programarle reglas fijas.

Deep Learning (DL): Es un tipo de ML que usa "Redes Neuronales Profundas". ¿Por qué "profundas"? Porque tienen muchas capas ocultas entre la entrada y la salida.

Es una "Caja Negra". Sabemos qué entra (Síntomas) y qué sale (Diagnóstico), pero lo que pasa en esas capas intermedias es un lío de millones de multiplicaciones que a veces ni los ingenieros entienden del todo. Es como la farmacocinética de un fármaco nuevo: sabemos que funciona, pero el mecanismo molecular exacto a veces se nos escapa.

El Corazón de ChatGPT/Gemini...: La Arquitectura "Transformer"

Las IAs generativas actuales (GPT, Claude, Gemini) se basan en una arquitectura llamada Transformer (Google, 2017). Y no, no son los robots de Optimus Prime (ojalá, sería más divertido).

La clave del Transformer es el Mecanismo de Atención. Antes, las IAs leían las frases palabra por palabra de izquierda a derecha. Se les olvidaba el principio de la frase cuando llegaban al final. El Transformer puede mirar toda la frase a la vez y decidir a qué palabras "prestar atención".

Analogía: Cuando leéis una historia clínica, vuestro cerebro ignora las preposiciones y se focaliza en "Dolor torácico", "Irradiado", "Brazo izquierdo". El Transformer hace lo mismo: asigna más "peso" a las palabras relevantes para entender el contexto global.

El Lenguaje de las Máquinas: Embeddings y Vectores

¿Cómo entiende un ordenador la palabra "Aspirina"? No puede. Los ordenadores solo entienden números. Aquí entra la magia vectorial. La IA convierte cada palabra en una lista de números (un vector) y la coloca en un espacio multidimensional.

Las palabras con significados similares se colocan "cerca" físicamente en ese mapa matemático.

- Paracetamol estará cerca de Ibuprofeno.

- Tibia estará cerca de Peroné pero lejos de Cerebro.

Esto permite hacer operaciones matemáticas con conceptos semánticos. La ecuación clásica que usamos los frikis es:

V(Rey) - V (Hombre) + V (Mujer) ≈ V (Reina)

La IA no "sabe" qué es una reina. Pero sabe que la relación matemática entre esos conceptos apunta a esa coordenada.

El Entrenamiento: La Residencia EIR de la IA

¿Cómo aprende esos "Pesos" y relaciones?

Pre-entrenamiento (La Facultad): Le damos a la IA terabytes de texto (todo internet). Su única misión es jugar a adivinar: "Oculto la siguiente palabra, intenta adivinarla. Si fallas, ajusto tus pesos (retropropagación) para que la próxima vez aciertes". Esto gasta una cantidad de energía brutal (GPUs).

Fine-Tuning / RLHF (La Residencia): Aquí entran humanos. La IA ya sabe hablar, pero es una sociópata. Los humanos revisan sus respuestas y le dan premios o castigos (Reinforcement Learning from Human Feedback). "No, no le digas al paciente cómo fabricar ántrax". "Sí, resume bien el protocolo".

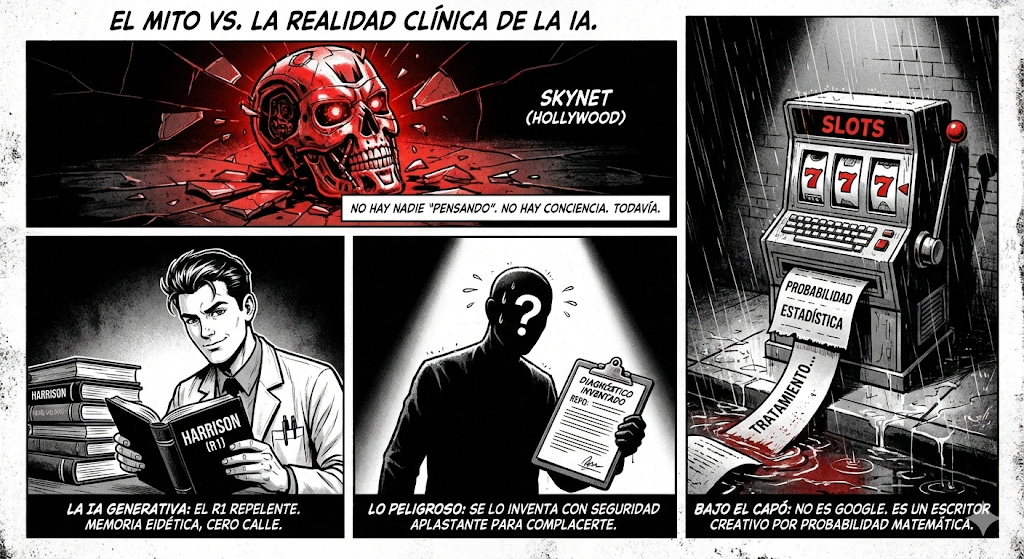

La antiexplicación de qué es la IA

Vamos a empezar matando un mito de Hollywood. Siento romperos el corazón, pero cuando hablamos de ChatGPT, Gemini o Claude, no estamos hablando de Skynet. No hay nadie "pensando" al otro lado de la pantalla. No hay conciencia, no hay alma, y ciertamente no hay ganas de dominar el mundo (todavía).

Técnicamente, interactuáis con Modelos Grandes de Lenguaje (LLMs). Pero como aquí nos gusta la filosofía práctica, usad esta analogía clínica:

La IA Generativa es como ese R1 (Residente de primer año) repelente que se ha memorizado el Harrison entero. 🤓

Lo bueno: Tiene memoria eidética. Se ha leído todos los papers, guías y protocolos hasta ayer por la tarde.

Lo malo: Cero calle. Cero ojo clínico. No ha tocado un paciente en su vida digital.

Lo peligroso: Sufre de una inseguridad patológica que compensa con arrogancia. Si no sabe la respuesta, se la inventa con una seguridad tan aplastante que te hace dudar hasta de tu propio nombre. Lo hace para complacerte a ti, su adjunto.

¿Qué pasa bajo el capó? Esto no es Google. Google es una biblioteca; la IA es un escritor creativo. Funciona por probabilidad estadística. No "sabe" lo que es la hipertensión, solo calcula matemáticamente qué palabra suele ir detrás de "tratamiento de la..." para que la frase suene bien. Es genial para razonar y escribir, pero es un desastre con la verdad absoluta.

La IA NO es inteligencia sensible

Lo que tenéis delante no es inteligencia sensible. Es un loro estocástico (probabilístico) extremadamente sofisticado.

Cuando la IA os responde de manera empática, no "siente" empatía. Ha calculado que, ante vuestras palabras de angustia, la secuencia de palabras con mayor probabilidad estadística de ser aceptada por un humano (basado en su entrenamiento RLHF) son palabras de consuelo.

Es un espejo matemático de nuestra propia humanidad, reflejada en los datos que hemos volcado en internet.